728x90

1️⃣ LLM(Large Language Model)이란

- LLM은 "Large Language Model"의 약자로, 대규모 데이터 세트에서 훈련된 인공지능 언어 모델을 의미한다. 이러한 모델은 자연어 처리(NLP, Natural Language Processing) 작업에 널리 사용되며, 텍스트 생성, 분류, 번역, 질문 응답, 감정 분석 등 다양한 작업을 수행할 수 있다.

- 일반적으로 LLM은 수백만 개 이상의 매개변수(parameter)를 가지고 있으며, 이는 모델이 다양한 언어 패턴과 구조를 학습할 수 있게 해준다. 그 결과로, LLM은 상당히 정교하고 자연스러운 텍스트를 생성할 수 있다.

- GPT3는 1750억개, 타 모델들도 기본 몇 십억~몇 백억개의 파라미터를 가진다.

- 예를 들어, GPT(Generative Pre-trained Transformer) 시리즈와 같은 모델은 OpenAI에 의해 개발되었고, 이는 대표적인 LLM의 한 예이다. 이러한 모델은 웹 페이지, 책, 논문, 기사 등의 큰 텍스트 데이터셋에서 훈련되며, 그 후에는 다양한 자연어 처리 작업에 적용될 수 있다.

- LLM은 현재 많은 상업적 응용 프로그램에서 사용되고 있으며, 챗봇, 검색 엔진, 자동 번역 서비스, 컨텐츠 추천 등 다양한 분야에서 그 가치가 인정되고 있다. 하지만 이러한 모델은 여전히 고도의 전문성을 필요로 하는 작업에는 한계가 있을 수 있으며, 잘못된 정보생성, 편향성, 이해 부족 등의 문제도 있을 수 있다.

2️⃣ LLM(Large Language Model)을 만들기 위해 필요한 것

- 대규모 텍스트 데이터 → LLM을 학습시키기 위해 필요

- 엄청난 연산량이 컴퓨팅 리소스 → LLM 파라미터수의 양이 방대하기 때문에 이를 학습시키기 위한 컴퓨팅 리소스 필요

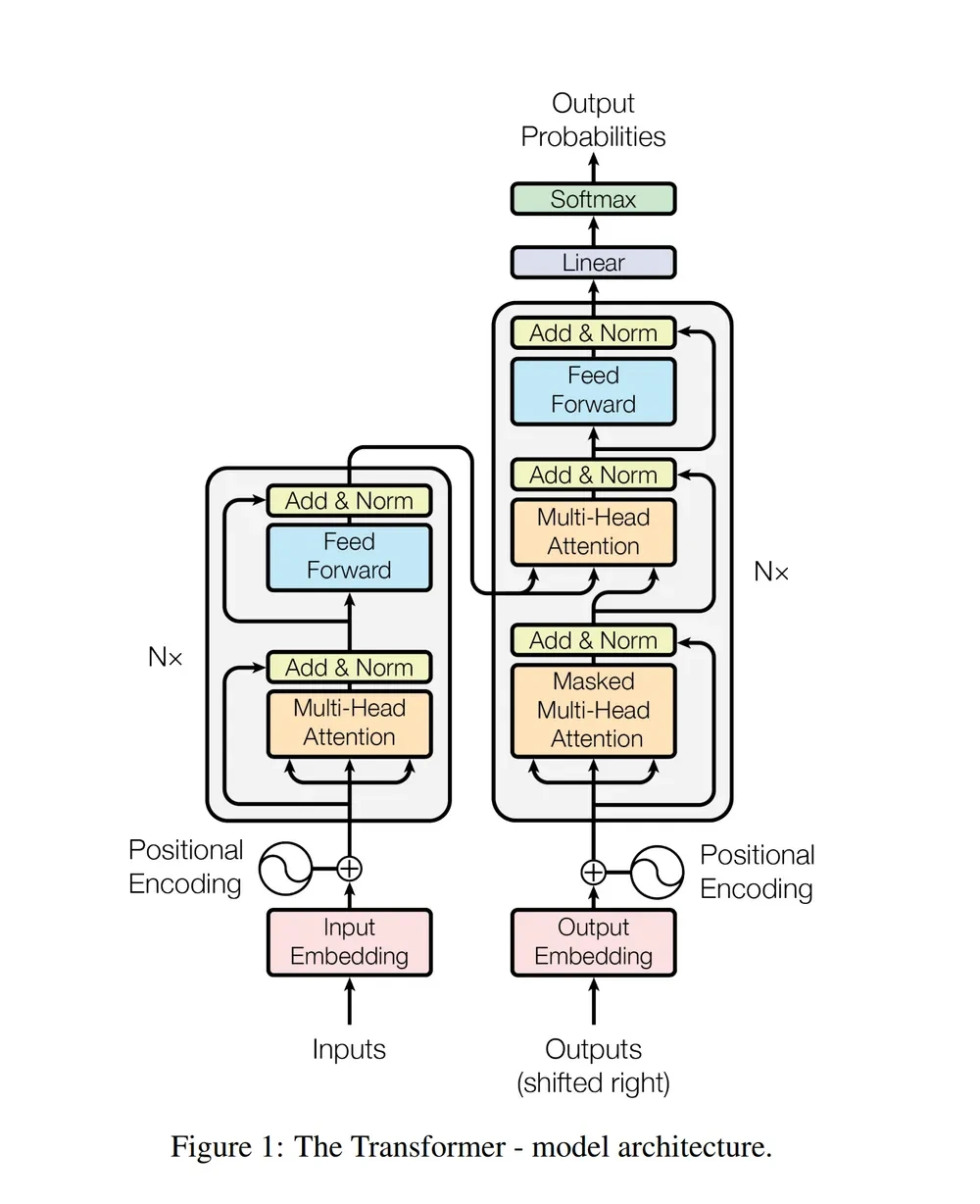

3️⃣ LLM(Large Language Model)에 사용되는 딥러닝 모델 - Transformer

대부분의 LLM(Large Language Model)은 트랜스포머(Transformer)딥러닝 모델을 사용한다.

4️⃣ LLM 학습의 기본 원리 - Language Model(LM)

- LLM 학습의 핵심 원리인 언어 모델(Language Model[LM])은 다음에 올 단어가 무엇인지를 예측하는 것이다.

- 예를 들어, 푸른 하늘에 OO이 떠있다. 라는 문장이 있을 때 사랑은 OO에 들어갈 단어가 구름이라는 것을 쉽게 예측할 수 있다.

5️⃣ ChatGPT의 기본 원리 - Language Model(LM)

- 이처럼 주어진 텍스트를 기반으로 다음에 어떤 텍스트가 오는게 적절한지를 머신러닝 기법으로 학습시키는 것을 언어 모델(Language Model[LM])이라고 한다.

- 언어 모델의 대표적인 예시로 구글이나 네이버에 검색어를 입력하면 검색어 뒤에 단어를 자동으로 제안해 주는 것이 있다.

6️⃣ Language Model(LM) - 데이터셋의 예시

- OO 하늘에 구름이 떠있다. → 정답: 푸른

- 푸른 OO에 구름이 떠있다. → 정답: 하늘

- 푸른 하늘에 OO이 떠있다. → 정답: 구름

- 푸른 하늘에 구름이 OOO. → 정답: 떠있다.

[정리]

LLM 아키텍처 → Transformer

학습시키는 알고리즘 → Language Modeling

7️⃣ 파운데이션 모델(Foundation Model)

- "파운데이션 모델(Foundation Models)"라는 용어는 주로 범용성이 높고 다양한 응용 분야에서 사용될 수 있는 대규모 머신 러닝 모델을 의미한다. 이러한 모델들은 일반적으로 막대한 양의 데이터에서 훈련되며, 사람의 언어 이해 능력을 모방하거나 초과할 수 있는 높은 성능을 지닌다.

- 대표적으로 GPT-3, GPT-4, BERT, RoBERTa 등의 언어 모델이 이에 해당한다.

- 파운데이션 모델은 다음과 같은 특징을 가진다.

- 범용성: 하나의 모델이 다양한 작업에 적용될 수 있다. 예를 들어 텍스트 생성, 번역, 요약, 질문 응답 등 다양한 자연어 처리 작업에서 사용될 수 있다.

- 전이학습(Transfer Learning) 가능: 파운데이션 모델은 일반적으로 특정 작업에 특화된 모델보다 더 많은 데이터로 훈련된다. 따라서 이러한 모델을 기반으로 작은 양의 추가 데이터로 특정 작업에 빠르게 적응할 수 있다.

- 데이터 효율성: 막대한 양의 데이터에서 훈련되기 때문에, 일반적으로 더 적은 양의 데이터로도 높은 성능을 나타낼 수 있다.

- 응용 분야의 다양성: 이러한 모델들은 자연어 처리뿐만 아니라 이미지 인식, 음성인식, 추천 시스템 등 다양한 분야에서도 활용될 수 있다.

- 윤리적, 사회적 이슈: 파운데이션 모델은 그 크기와 범용성 때문에 편향성, 해석 가능성, 데이터 프라이버시 등 여러 윤리적, 사회적 문제를 수반할 수 있다.

- 파운데이션 모델은 현재 다양한 산업과 연구 분야에서 광범위하게 활용되고 있으며, 이러한 모델들의 중요성과 영향력은 계속해서 증가하고 있다.

- 기업별로 대표적인 파운데이션 모델들은 다음과 같다.

- OpenAI - GPT(GPT-1, GPT-2, GPT-3, GPT-3.5, GPT-4)

- Meta(Facebook) - Llama1, Llama2

- Google - PaLM

8️⃣ Reinforcement Learning from Human Feedback(RLHF)

- 기초 Foundation Model 들을 제품화하기 위해서 Reinforcement Learning from Human Feedback(RLHF) 기법이 사용된다.

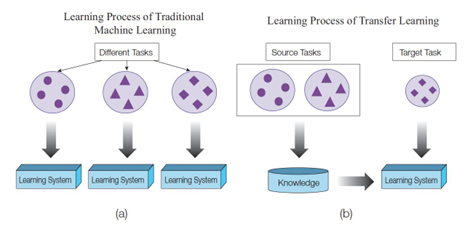

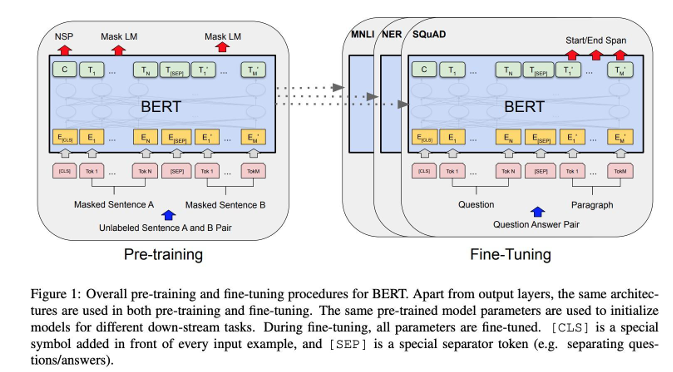

9️⃣ 전이 학습(Transfer Learning)

- 전이 학습(Transfer Learning) 또는 Fine-Tuning 이라고 부르는 기법은 이미 학습된 Neural Networks의 파라미터를 새로운 Task에 맞게 다시 미세조정(Fine-Tuning)하는 것을 의미한다.

- 컴퓨터 비전 문제 영역에서는 ImageNet 등의 데이터셋에 미리 Pre-Training 시키고 이 파라미터들을 내가 풀고자 하는 문제에 맞게 Fine-Tuning 하는 과정이 광범위하게 사용되고 있었다.

- 최근에는 BERT, GPT같은 대규모 자연어 처리 모델이 등장하면서 자연어 처리 문제 영역에서도 전이 학습의 개념이 광범위하게 사용되고 있다.

- 대량의 corpus 데이터셋으로 Pre-training → 목적에 맞게 Fine-Tuning

- 대규모 Text Corpus로 학습된 LLM 이라도 모든 것을 알 순 없다. 목적에 맞는 Fine-Tuning을 통해 목적에 맞는 데이터와 상황에 맞게 학습한다면 범용적인 LLM 보다 더 강력한 커스텀 LLM을 만들 수 있다.

🔟 LLM의 잠재적 위험성 - 편향(Bias)과 할루시네이션(Hallucination)

- LLM(Large Language Models)은 다양한 문제와 과제들을 처리할 수 있지만, 편향(Bias)과 할루시네이션(Hallucination)과 같은 문제들도 있다.

- 편향(Bias):

- 데이터로부터의 편향: LLM은 대규모 데이터셋에서 훈련되기 때문에, 그 데이터셋에 내재된 사회적, 문화적 편향을 학습할 수 있다. 이로 인해 모델은 성별, 인종, 지역 등에 대한 편견을 반영할 가능성이 있다.

- 확인 편향(Confirmation Bias): 모델은 때로 사용자의 의견이나 선입견을 더 깊게 뿌리내릴 수 있다. 예를 들어, 모델에게 특정 주제에 대한 의견을 물으면, 사용자가 원하는 대답을 하려고 하는 경향이 있을 수 있다.

- 편향의 증폭: 모델이 특정 집단이나 개념에 대한 더 극단적인 또는 편향된 정보를 생성하거나 전달하는 경우도 있다.

- 할루시네이션(Hallucination):

- 정보의 부정확성: LLM은 때로는 현실과 다른, 부정확한 정보를 생성할 수 있다.

- 추론 오류: 모델이 문맥을 정확히 이해하지 못하여 잘못된 추론을 하는 경우도 있다.

- 데이터 왜곡: 모델이 훈련 데이터에 없던 정보를 '생성'할 수도 있다. 이러한 정보는 현실과 다를 수 있으며, 이를 믿는 것은 위험할 수 있다.

- 물론 이러한 문제들을 해결하려는 다양한 연구와 노력이 진행 중이다. 편향을 감지하고 수정하는 알고리즘, 모델의 해석 가능성을 높이는 방법, 사용자에게 모델의 한계와 위험성으르 명확하게 알려주는 인터페이스 등이 개발되고 있다. 하지만 이러한 문제들은 LLM의 복잡성과 대규모 데이터에 기반하기 때문에 완전히 해결하기는 어렵다. 따라서 이러한 문제의식을 가지고 모델을 사용하는 것이 중요하다.

728x90

'AI & 딥러닝' 카테고리의 다른 글

| LLM 용어 정리 - 토크나이징 (0) | 2025.02.26 |

|---|---|

| 기업별 대표 LLM 사용 및 비교해보기 ChatGPT, Bard, CLOVA X (0) | 2025.02.25 |

| [23강] 인공지능관련 개발자 / 전문가로서의 전망 (1) | 2024.12.02 |

| [22강] 인공지능의 한계와 미래 전망 (1) | 2024.12.02 |

| [21강] 음성 인식 기술과 활용 사례 (1) | 2024.12.02 |