🟪 Imbalanced datasets

불균형 데이터셋은 특정 클래스(예: 사기, 청구 등)가 전체 데이터에서 매우 희귀한 경우를 말한다.

대부분의 모델은 다수 클래스를 위주로 학습해서, 소수 클래스(이상치)를 제대로 예측하지 못한다.

아래에서 예시로 사용될 Porto Seguro의 안전 운전자 예측 대회는 불균형한 클래스 문제의 대표적 예시이다.

전체 고객 중 보험금 청구는 드문 사건이기 때문이다.

이 외에도 대표적인 불균형 클래스 문제로는 금융 사기 탐지나 컴퓨터 네트워크 공격 탐지 등이 있다.

🟪 The metric trap(평가지표의 함정)

불균형 데이터셋을 다룰 때 초보자들이 자주 빠지는 큰 함정 중 하나는 평가지표 선택에 있다.

예를 들어, accuracy_score(정확도) 같은 단순한 지표만을 사용한다면, 불균형 클래스 문제에서는 모델이 항상 가장 많은 클래스만 예측해도 겉으로는 높은 정확도를 보여줄 수 있다. 하지만 이는 사실상 아무것도 예측하지 않은 결과나 마찬가지다.

불균형 데이터셋에서는 어떤 평가지표를 선택하느냐가 매우 중요한데 여기서는 Normalized Gini Coefficient라는 지표를 사용한다. 이 지표는 무작위 추측일 경우 약 0, 완벽한 예측일 경우 약 0.5에 가까운 값을 갖는다.

🟪 Confusion matrix(혼동 행렬)

결과를 평가하는 방법 중 하나는 혼동 행렬(confusion matrix)을 이용하는 것이다.

이 행렬은 각 클래스에 대해 맞게 예측한 것과 틀리게 예측한 것을 한눈에 보여준다.

| 예측 결과 | 0(Negative) | 1(Positive) |

| 실제 0 | 진짜 0을 0으로 예측(TP) | 0을 1로 예측(FP) |

| 실제 1 | 1을 0으로 예측(FN) | 진짜 1을 1로 예측(TN) |

🟪 Resampling(Under-sampling, Over-sampling)

심하게 불균형한 데이터셋을 다룰 때 널리 사용되는 기법 중 하나가 Resampling이다.

이 기법은 크게 두 가지 방식으로 구성된다.

- Under-sampling: 다수 클래스에서 일부 샘플을 제거

- Over-sampling: 소수 클래스의 샘플을 복제하거나 추가

이러한 리샘플링 기법은 클래스 간 균형을 맞출 수 있다는 장점이 있지만, 모든 기법이 그렇듯 단점도 존재한다.

- Under-sampling은 다수 클래스에서 무작위로 일부 데이터를 제거하는 것이며, 이는 정보 손실(loss of information)을 초래할 수 있다.

- Over-sampling은 소수 클래스에서 무작위로 샘플을 복제하는 것인데, 이 방식은 과적합(overfiitting)을 유발할 수 있다.

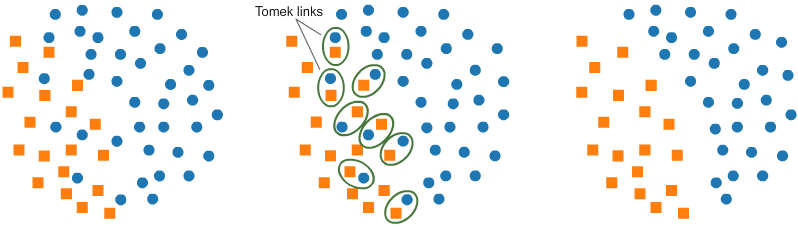

🟪 Under-sampling: Tomek links

Tomek links는 서로 다른 클래스지만 아주 가까운 거리에 위치한 샘플 쌍을 말한다.

이때 각 쌍에서 다수 클래스에 해당하는 샘플을 제거하면, 두 클래스 간의 경계가 명확해지고, 결과적으로 분류를 더 쉽게 만들 수 있다.

🟪 Under-sampling: Cluster Centroids

Cluster Centroids는 클러스터링 기반으로 중심점(centroids)을 생성해 언더샘플링을 수행한다.

즉, 데이터를 유사도에 따라 미리 클러스터(군집)으로 묶은 뒤, 그 클러스터의 중심값(centroid)만을 남겨 정보 손실을 최소화하면서 샘플 수를 줄인다.

무작위로 제거하는 일반적인 Under-sampling 보다 정보 손실이 적고, 대표성 있는 샘플만 유지할 수 있다는 장점이 있다.

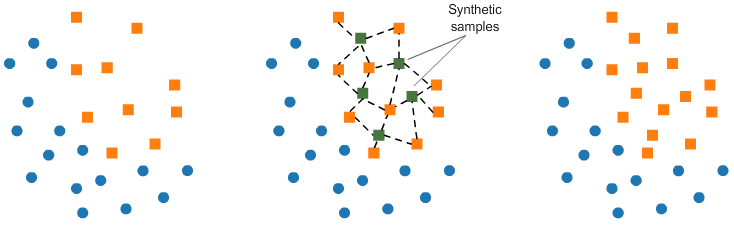

🟪 Over-sampling: SMOTE

SMOTE는 Synthetic Minority Oversampling Technique의 약자로, 기존 소수 클래스의 데이터를 기반으로 새로운 합성 샘플을 생성하는 방식이다.

이 기법은

- 소수 클래스에서 임의의 데이터 포인트를 선택하고,

- 해당 포인트의 k개의 최근접 이웃(k-nearest neighbors)을 찾는다.

- 그리고 선택된 포인트와 이웃 사이의 공간에 새로운 데이터 포인트를 생성한다.

즉, 기존 데이터를 단순히 복제하는 것이 아니라 새롭고 다양한 데이터를 만들어냄으로써 과적합을 줄이고 일반화 성능을 높이는 장점이 있다.

'AI & 딥러닝' 카테고리의 다른 글

| OCR AI 자동맵핑 알고리즘 (Google Vision API, tkinter) (2) | 2025.05.20 |

|---|---|

| LLM 용어 정리 - 온도(Temperature) (0) | 2025.02.26 |

| LLM 용어 정리 - 창발 능력(Emergent Abilites) (0) | 2025.02.26 |

| LLM 용어 정리 - In-context learning (1) | 2025.02.26 |

| LLM 용어 정리 - 토크나이징 (0) | 2025.02.26 |